Le unità di misura in informatica: byte, hertz e pixel

Viviamo in un’era digitale, un periodo in cui le informazioni sono trasmesse, elaborate e visualizzate con una velocità e una precisione senza precedenti. Ma come quantifichiamo e misuriamo questi dati? Come possiamo comprendere la capacità di memoria di un dispositivo, la velocità di un processore o la risoluzione di uno schermo? La risposta risiede nelle unità di misura informatiche: bit, byte, hertz e pixel. Queste unità sono i pilastri fondamentali su cui poggia il nostro mondo digitale.

Il bit, acronimo di “binary digit", è la più piccola unità di dati in informatica. È un segnale elettronico che può assumere uno di due valori: 0 o 1. Da questa singola unità binaria nasce tutto ciò che definiamo informazione digitale. Il byte, composto da otto bit, rappresenta un dato informatico standard, capace di codificare un singolo carattere di testo in un documento.

Ma l’informatica non si ferma alla semplice rappresentazione dei dati. La velocità con cui questi dati vengono elaborati è fondamentale: qui entra in gioco l’unità hertz (Hz), che misura la frequenza. Nell’ambito dei computer, indica quante operazioni può eseguire un processore in un secondo. Pertanto, un processore con una frequenza di 2 gigahertz (GHz) può eseguire due miliardi di operazioni al secondo.

E, infine, il pixel, la più piccola unità individuale di un’immagine. Ogni schermo che utilizziamo, dallo smartphone al televisore, è composto da migliaia o milioni di pixel. Ogni pixel ha un colore specifico, e insieme creano le immagini che vediamo. La densità dei pixel determina la nitidezza e la chiarezza delle immagini visualizzate.

In questo articolo cercheremo proprio di capire meglio cosa sono tutte queste unità di misura, qual è la loro funzione e quando possono tornarci utili… ad esempio, nella scelta del nostro nuovo cellulare!

- Quali sono e a cosa servono le unità di misura informatiche

- Bit e byte: unità di misura informatiche per la memorizzazione

- Hertz: unità di misura informatica della frequenza

- Pixel: unità di misura informatica per la risoluzione

Quali sono e a cosa servono le unità di misura informatiche

Abbiamo parlato di lunghezza, massa, capacità, tempo… Ma ci sono delle unità di misura che sono entrate nel nostro quotidiano e non ce ne rendiamo nemmeno conto: le unità di misura informatiche.

Parlando di computer, cellulari, memorie… Entrano in gioco megabyte, gigabyte, ma anche hertz e pixel.

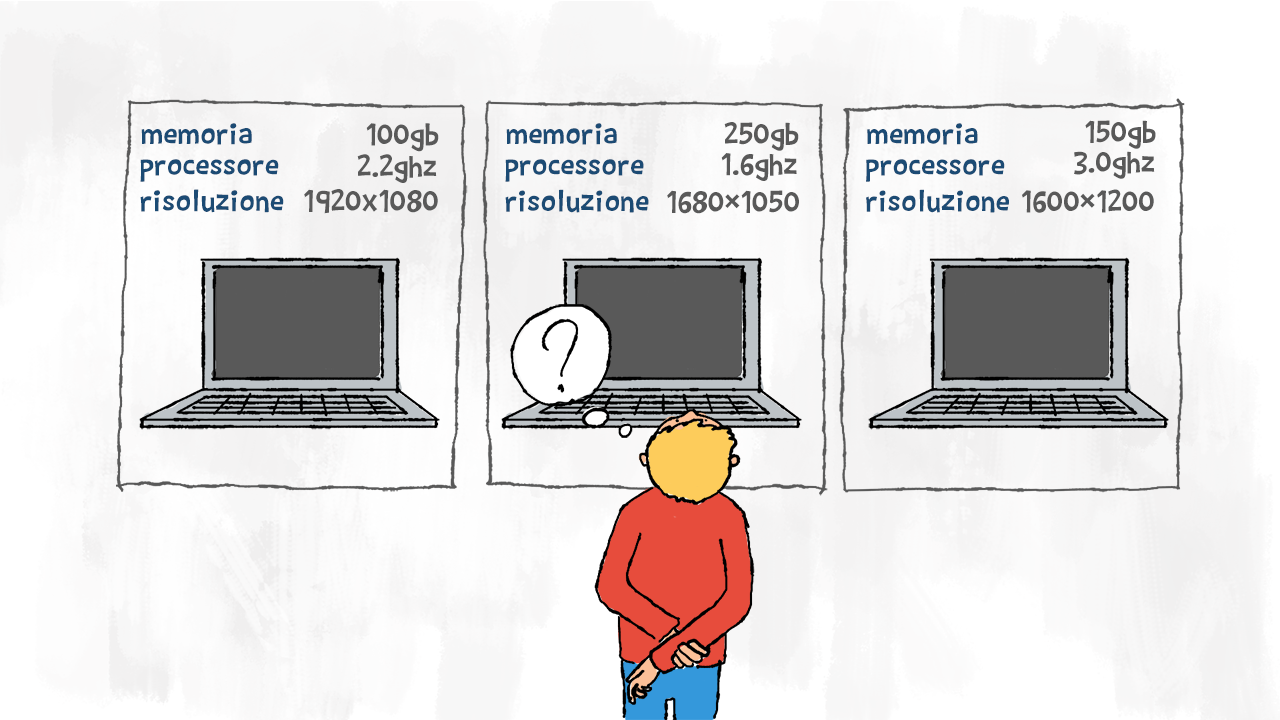

Scopriamo a cosa servono tutte queste unità di misura, magari non ci ritroveremo nella situazione del ragazzo nell’immagine! 😉

Bit e byte: unità di misura informatiche per la memorizzazione

L’unità di misura che utilizziamo maggiormente in campo informatico è il byte. Si tratta dell’unità di misura utilizzata per la memorizzazione delle informazioni. Questo termine nasce da “a bite of it" che significa “un boccone di bit", cioè un insieme di informazioni.

Un bit è l’unità elementare dell’informazione: bit deriva da BInary digiT, cioè cifra binaria. Infatti un bit raccoglie un singolo carattere che può essere lo 0 o l’1, i caratteri del sistema binario. Noi contiamo utilizzando il sistema decimale, cioè con 10 cifre dallo 0 al 9. In informatica, invece, bastano lo 0 e l’1 per rappresentare tantissime informazioni.

Il processore di un computer può essere a

32 bit o a 64 bit. Ma qual è la differenza? Tutto sta nel sistema di gestione delle informazioni.In termini di prestazioni, un computer a 64 bit, è in grado di gestire un maggior numero di informazioni contemporaneamente, quindi è in grado di svolgere un maggior numero di istruzioni; tuttavia in termini di consumo energetico, potrebbe essere migliore un computer a 32 bit.

Per programmare, si sono raggruppati più bit in sequenze più vaste che raccolgono quindi più informazioni: i byte sono la somma di 8 bit. Vediamo tutte le unità di misura dell’informazione: anche il bit ha i suoi multipli. Per ogni unità di misura indichiamo il numero di valori possibili in termini di potenze di 2:

- b = bit = 2 caratteri (acceso – spento)

- B = byte = 8 b = £$ 2^8 $£ caratteri = 256 caratteri

- KB = kilobyte = 1024 byte = £$ 2^{10} $£ byte

- MB = megabyte = 1024 KB = £$ 2^{20} $£ byte

- GB = gigabyte = 1024 MB = £$ 2^{30} $£ byte

- TB = terabyte = 1024 GB = £$ 2^{40} $£ byte

- PB = petabyte = 1024 TB = £$ 2^{50} $£ byte

- HB = hexabyte = 1024 PB = £$ 2^{60} $£ byte

Quando leggiamo le informazioni sulla capacità di memoria di un nuovo smartphone o di un super computer, facciamo attenzione alle unità di misura! Noterai che le dimensioni sono espresse quasi sempre utilizzando le potenze di 2: troviamo smartphone con memorie da 8 GB, 16 GB, 32 GB… Ti ricordano qualcosa? Sono tutte potenze di 2. In informatica si è sempre espresso tutto utilizzando le potenze di 2. Li usiamo anche per le dimensioni delle unità di memoria perché rappresentano il valore più esatto della quantità di dati che può contenere una determinata unità di memoria. Spesso troviamo anche hard disk con capacità espressa usando i multipli di 10: questa è più che altro una trovata commerciale. Fai sempre attenzione alla capacità reale di un hard disk prima di acquistarlo!

Hertz: unità di misura informatica della frequenza

Stai per acquistare un nuovo cellulare e sei indeciso tra due che sono apparentemente uguali. Cambia solo il numerino scritto di fianco alla voce processore: quale conviene comprare? Sicuramente il numero più grande corrisponde ad una potenza maggiore del cellulare, ma anche ad un maggior consumo di batteria.

La velocità del processore di un cellulare di solito è misurata in GHz, cioè gigahertz. L’unità di misura della frequenza è l’hertz. Prende il suo nome dal fisico Heinrich Hertz che ha dato un apporto fondamentale alla scienza nel campo dell’elettromagnetismo. L’hertz misura la velocità con cui è eseguita un’operazione.

Anche l’hertz ha i suoi multipli e sottomultipli:

- daHz = deca-hertz £$ = 10^1 $£ Hz

- hHz = etto-hertz £$ = 10^2 $£ Hz

- kHz = kilo-hertz £$ = 10^3 $£ Hz

- MHz = mega-hertz £$ = 10^6 $£ Hz

- GHz = giga-hertz £$ = 10^9 $£ Hz

- THz = tera-hertz £$ = 10^{12} $£ Hz

- PHz = peta-hertz £$ = 10^{15} $£ Hz

- EHz = exa-hertz £$ = 10^{18} $£ Hz

- ZHz = zetta-hertz £$ = 10^{21} $£ Hz

- YHz = yotta-hertz £$ = 10^{24} $£ Hz

Pixel: unità di misura informatica per la risoluzione

Un’ultima cosa importante nella scelta di un nuovo smartphone è la risoluzione dello schermo e magari anche della fotocamera. Questa si misura in pixel: il termine deriva dalla contrazione di picture element e indica ciascuno degli elementi puntiformi che compongono la rappresentazione di un’immagine digitale. Quindi un pixel è la più piccola parte di un’immagine.

Il numero di pixel che possiamo visualizzare viene definito come risoluzione indica la quantità di dettagli fini che possono essere rappresentati nell’immagine.

Per indicare il numero di pixel che una fotocamera può riprodurre viene solitamente utilizzato un solo numero; per indicare invece il numero di pixel che vediamo in un display viene utilizzato un prodotto, pixel in larghezza per pixel in altezza, per questo la risoluzione di uno schermo dipende soprattutto dalla sua grandezza.

Quindi quando scegliamo il nostro nuovo smartphone, dobbiamo fare attenzione anche a questi dettagli: quanto è definito lo schermo? Quanto è precisa la fotocamera?

Il pixel si indica con il simbolo px. Parlando di fotocamera, abbiamo sicuramente sentito parlare dei multipli: un megapixel equivale a un milione di pixel. Ogni tanto troviamo anche il gigapixel, ma è utilizzato più che altro per le schede grafiche.